Hur utvecklas hårdvaran?

Hittills har utvecklingen av datorer varit stabil: effektiviteten har ökat exponentiellt i flera decennier. Men kommer det fortsätta så? Kan det fortsätta så? Vad händer om vi når en punkt där vår hårdvara inte kan förbättras?

Hårdvaran kan inte bli mindre

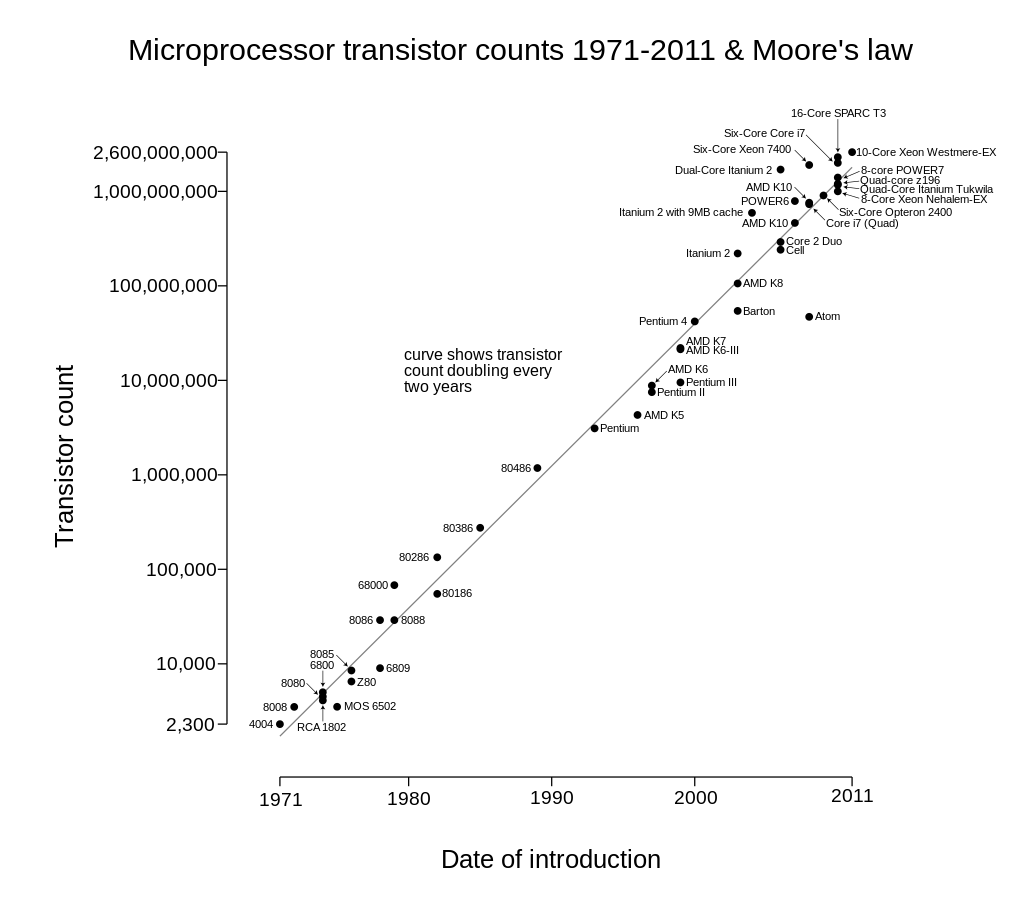

Antalet transistorer på en mikroprocessor genom från år 1971-2011. Bild tagen Från Wikipedia

Moores lag säger att transistortätheten, det vill säga antalet transistorer som får plats på en processor, fördubblas vartannat år. Denna lag har hållit ända sedan Gordon Moore, en av Intels grundare, sade att det var 1975. Anledningen till varför den har varit så viktig är för att transistorerna är de delarna av processorn som kan hålla data och gör därmed att processorn kan utföra beräkningar. När processorn har fler transistorer kan den göra fler beräkningar samtidigt, vilket leder till att komponenterna och datorn blir mer effektiva. Däremot börjar vi nu närma oss en punkt där vissa komponenter är så små att de inte kan förminskas mer, och processorn är en sådan komponent. Processorn, eller CPU:n(Central Processing Unit), är en av de viktigaste komponenterna i hela datorn. Den kan liknas till en hjärna, då den gör alla beräkningar på datorn. Som tidigare nämnt sitter transistorerna på processorn. Transistorerna var väldigt stora förr i tiden, men enligt artikeln “How Small Can Transistors Get?”(Wafer World, 24/11-2021) kan man nuförtiden förvänta sig att se 3nm transistorer, och att även 1nm transistorer har skapats. Absolutgränsen för hur små transistorerna kan bli är 1 atom stora, eller 30-300pm(0.03-0.3nm). Däremot går gränsen i praktiken långt före det, då det enligt artikeln “Are processors pushing up against the limits of physics?”(Ars Technica, 14/8/2014) blir svårt att kontrollera elektriciteten vid tillräckligt små storlekar. Det betyder att vi till slut kommer nå en punkt där hårdvaran som den fungerar nu inte kan bli mindre, så det enda alternativet är att göra större datorer. Så visa vi inte hittar alternativa sätt att bygga datorerna.

Alternativ 1: Kvantdatorer

Ett alternativ till vanliga datorer är kvantdatorer. Väldigt enkelt förklarat kan man säga att en kvantdator fungerar som en vanlig dator, men med qubits istället för bits. Artikeln “ Fast Forward: How much smarter can computers get?”(4/1-2024) av Science World beskriver skillnaden som att en bit kan hålla antingen en etta eller en nolla, medan en qubit kan vara en etta och en nolla samtidigt. Det innebär att qubits kan hålla i mer data och även göra uträkningar snabbare än vad en vanlig kan. Om kvantdatorer fungerar skulle de komma runt de fysiska begränsningar som finns på vanliga datorer och kunna fortsätta utvecklas.

Om du vill lära dig mer om kvantdatorer kan du läsa den här texten om just det.

Alternativ 2: Förbättrad mjukvara

Ett annat sätt att förbättra datorer när hårdvaran inte längre kan förbättras är att förbättra mjukvaran. Eftersom Moores lag har gällt än så länge har det aldrig krävts att mjukvaran ska bli mer effektiv. Istället har man kunnat fokusera på att endast göra mjukvaran starkare och bättre, och ignorerat storleken och effektiviteten då man alltid kunnat lita på att hårdvaran kommer ha förbättrats tillräckligt mycket för att hantera allt man kunnat slänga mot dem. Om hårdvaruförbättringen saktas in kommer detta system inte längre fungera. Då måste man hitta något nytt att effektivisera, och en möjlighet är då att förbättra mjukvaran. Det hade lett till att man inte längre skulle vara begränsad till de fysiska gränser som finns för hårdvara, eftersom man endast arbetar med kod.

Ett sätt att förbättra mjukvaran skulle vara med hjälp av artificiell intelligens. AI fungerar på ett väldigt annat sätt än vanliga datorer. Artikeln “What’s the Difference Between AI and Regular Computing?”(The Royal Institution, 12/12-2023) skriver att de räknar på ett sätt som är mycket mer likt en människa istället för det rent logiska sättet som en vanlig dator gör. Det betyder att de kan göra uträkningar utan att lägga samma press på processorn eftersom processorn inte behöver räkna ut varenda del. Däremot har AI ett stort problem: det drar mycket energi. En studie, “The Environmental Impact of AI: A Case Study of Water Consumption by Chat GPT”(A. Shaji George, A. S. Hovan George & A. S. Gabrio Martin, 20/4-2023), undersöker vattenkonsumtionen för ChatGPT och andra AI-modeller. Studien upptäckte att sådana AI-modeller kräver mycket vatten och att det kan ha en negativ effekt på miljön. Studien fortsätter däremot med att nämna att dessa problem kan lösas om man exempelvis hittar sätt att effektivisera modellerna så att de inte drar lika mycket energi.

Källor

- Ars Technica: https://arstechnica.com/science/2014/08/are-processors-pushing-up-against-the-limits-of-physics/

- Wafer World: https://www.waferworld.com/post/how-small-can-transistors-get

- Wikipedia - Atomic Radius: https://en.wikipedia.org/wiki/Atomic_radius

- Science World: https://www.scienceworld.ca/stories/fast-forward-how-much-smarter-can-computers-get/

- Royal Institution: https://www.rigb.org/explore-science/explore/blog/whats-difference-between-ai-and-regular-computing

- Tekniska Museet: https://www.tekniskamuseet.se/lar-dig-mer/100-innovationer/transistorn/

- Intel: https://www.intel.com/content/www/us/en/newsroom/resources/moores-law.html"